- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

- 8 H100 80GB NVlink

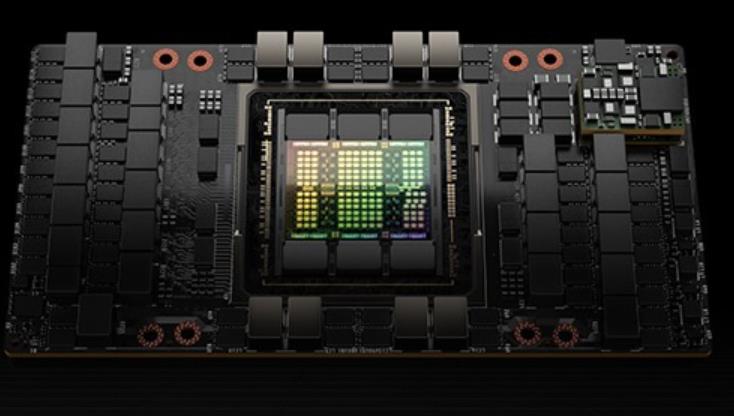

使用TSMC4nm工艺定制800亿个晶体管,814mm²芯片面积。NVIDIAGraceHopperSuperchipCPU+GPU架构NVIDIAGraceCPU:利用ARM架构的灵活性,创建了从底层设计的CPU和服务器架构,用于加速计算。H100:通过NVIDIA的超高速片间互连与Grace配对,能提供900GB/s的带宽,比PCIeGen5快了7倍目录H100GPU主要特征基于H100的系统和板卡H100张量架构FP8数据格式用于加速动态规划(“DynamicProgramming”)的DPX指令L1数据cache和共享内存结合H100GPU层次结构和异步性改进线程块集群(ThreadBlockClusters)分布式共享内存(DSMEM)异步执行H100HBM和L2cache内存架构H100HBM3和HBM2eDRAM子系统H100L2cache内存子系统RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink网络第三代NVSwitch新的NVLink交换系统PCIeGen5安全性增强和保密计算H100video/IO特征H100GPU主要特征新的流式多处理器(StreamingMultiprocessor,SM)第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加。MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍。H100 GPU 特惠销售,快来选购。DubaiH100GPU库存

H100 GPU 采用了 NVIDIA 的架构技术,其架构采用 Ampere 架构,使其在性能和能效方面都达到了一个新的高度。H100 GPU 具有 8192 个 CUDA ,能够提供极高的并行处理能力,对于需要大量计算资源的任务,如深度学习训练和科学计算,H100 GPU 能够提升效率。其基础时钟频率为 1410 MHz,增强时钟频率可达 1665 MHz,确保在高负载下依然能够提供稳定的性能输出,其 Tensor Core 性能可达 312 TFLOPS,特别适合深度学习和神经网络训练等需要大量矩阵运算的任务,极大地提升了计算效率。硬盘H100GPU stockH100 GPU 限时降价,数量有限。

H100GPU是英伟达推出的一款高性能图形处理器,专为满足当今数据密集型计算任务的需求而设计。它采用了的架构,具备超高的计算能力和能效比,能够提升各种计算任务的效率和速度。无论是在人工智能、科学计算还是大数据分析领域,H100GPU都能提供的性能和可靠性。其强大的并行处理能力和高带宽内存确保了复杂任务的顺利进行,是各类高性能计算应用的。H100GPU拥有先进的散热设计,确保其在长时间高负荷运行时依然能够保持稳定和高效。对于需要长时间运行的大规模计算任务来说,H100GPU的可靠性和稳定性尤为重要。它的设计不仅考虑了性能,还兼顾了散热和能效,使其在保持高性能的同时,依然能够节省能源成本。无论是企业级应用还是科学研究,H100GPU都能够为用户提供持续的高性能支持。在人工智能应用中,H100GPU的强大计算能力尤为突出。它能够快速处理大量复杂的模型训练和推理任务,大幅缩短开发时间。H100GPU的并行计算能力和高带宽内存使其能够处理更大规模的数据集和更复杂的模型结构,提升了AI模型的训练效率和准确性。此外,H100GPU的高能效比和稳定性也为企业和研究机构节省了运营成本,是人工智能开发的理想选择。对于科学计算而言,H100GPU提供了的计算能力。

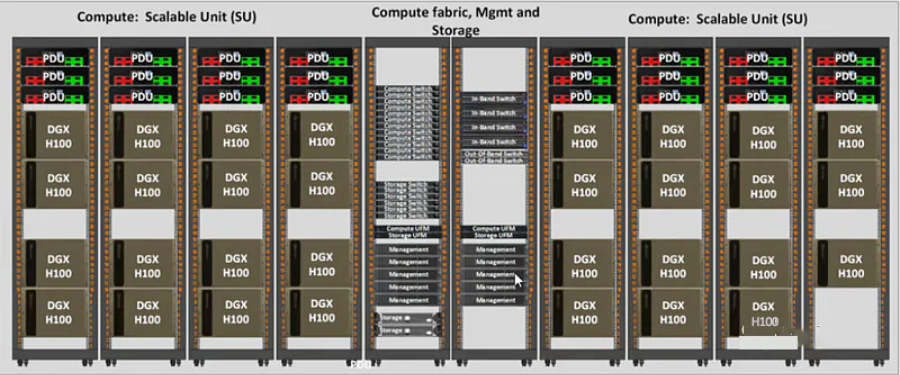

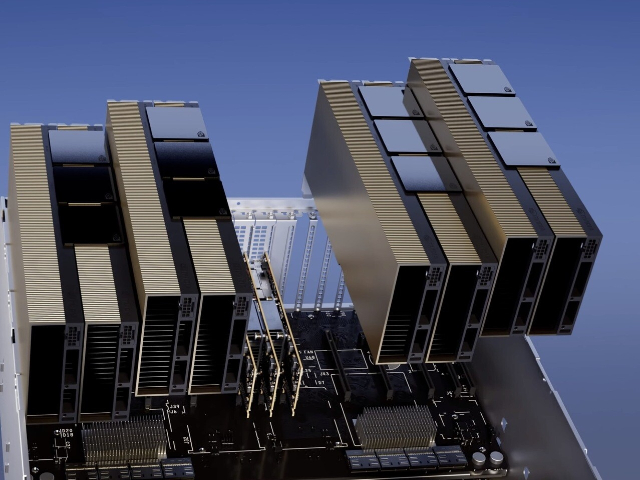

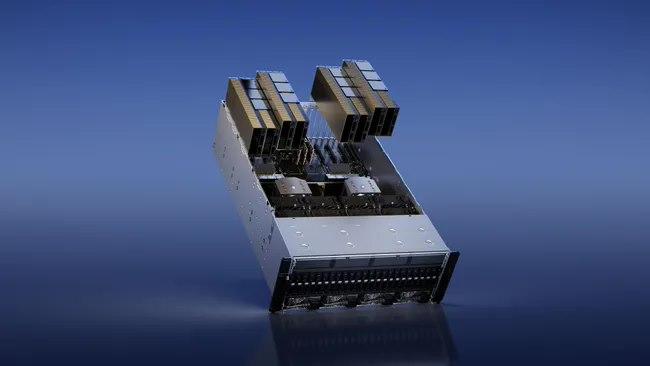

基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户,通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch,以提供SHARP在网络中的缩减和任意对GPU之间900GB/s的完整NVLink带宽。H100SXM5GPU还被用于功能强大的新型DGXH100服务器和DGXSuperPOD系统中。H100PCIeGen5GPU以有350W的热设计功耗(ThermalDesignPower,TDP),提供了H100SXM5GPU的全部能力该配置可选择性地使用NVLink桥以600GB/s的带宽连接多达两个GPU,接近PCIeGen5的5倍。H100PCIe非常适合主流加速服务器(使用标准的架构,提供更低服务器功耗),为同时扩展到1或2个GPU的应用提供了很好的性能,包括AIInference和一些HPC应用。在10个前列数据分析、AI和HPC应用程序的数据集中,单个H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,同时消耗了50%的功耗。DGXH100andDGXSuperPODNVIDIADGXH100是一个通用的高性能人工智能系统。H100 GPU 的高性能计算能力为此类任务提供了极大支持。

每个GPU实例在整个内存系统中都有单独的和孤立的路径--片上的交叉开关端口、L2缓存库、内存控制器和DRAM地址总线都是分配给单个实例的。这保证了单个用户的工作负载可以以可预测的吞吐量和延迟运行,具有相同的L2缓存分配和DRAM带宽,即使其他任务正在冲击自己的缓存或使其DRAM接口饱和。H100MIG改进:提供完全安全的、云原生的多租户、多用户的配置。Transformer引擎Transformer模型是当今从BERT到GPT-3使用的语言模型的支柱,需要巨大的计算资源。第四代NVLink和NVLink网络PCIe以其有限的带宽形成了一个瓶颈。为了构建强大的端到端计算平台,需要更快速、更可扩展的NVLink互连。NVLink是NVIDIA公司推出的高带宽、高能效、低延迟、无损的GPU-to-GPU互连。其中包括弹性特性,如链路级错误检测和数据包重放机制,以保证数据的成功传输。新的NVLink为多GPUIO和共享内存访问提供了900GB/s的总带宽,为PCIeGen5提供了7倍的带宽。A100GPU中的第三代NVLink在每个方向上使用4个差分对(4个通道)来创建单条链路,在每个方向上提供25GB/s的有效带宽,而第四代NVLink在每个方向上使用2个高速差分对来形成单条链路,在每个方向上也提供25GB/s的有效带宽。引入了新的NVLink网络互连。H100 GPU 支持多 GPU 配置。深圳H100GPU stock

能够实现更加复杂和逼真的游戏画面。DubaiH100GPU库存

使用张量维度和块坐标来定义数据传输,而不是每个元素寻址。TMA操作是异步的,利用了基于共享内存的异步屏障。TMA编程模型是单线程的,选择一个经线程中的单个线程发出一个异步TMA操作(cuda::memcpy_async)来复制一个张量,随后多个线程可以在一个cuda::barrier上等待完成数据传输。H100SM增加了硬件来加速这些异步屏障等待操作。TMA的一个主要***是它可以使线程自由地执行其他的工作。在Hopper上,TMA包揽一切。单个线程在启动TMA之前创建一个副本描述符,从那时起地址生成和数据移动在硬件中处理。TMA提供了一个简单得多的编程模型,因为它在复制张量的片段时承担了计算步幅、偏移量和边界计算的任务。异步事务屏障(“AsynchronousTransactionBarrier”)异步屏障:-将同步过程分为两步。①线程在生成其共享数据的一部分时发出"到达"的信号。这个"到达"是非阻塞的。因此线程可以自由地执行其他的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)。DubaiH100GPU库存

- 超微H100GPU库存 2024-11-15

- DubaiH100GPU价格 2024-11-15

- QatarH100GPU库存 2024-11-15

- DubaiNVLINKH100GPU 2024-11-15

- 技嘉H100GPU促销 2024-11-15

- 重庆H100GPU总代 2024-11-15

- 香港H100GPU price 2024-11-15

- 重庆超微H100GPU 2024-11-15

- IranH100GPU促销 2024-11-15

- NVLINKH100GPU 2024-11-14

- LenovoH100GPU库存 2024-11-14

- xfusionH100GPU price 2024-11-14