- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

- 8 H100 80GB NVlink

在游戏开发领域,H100 GPU 提供了强大的图形处理能力和计算性能。它能够实现复杂和逼真的游戏画面,提高游戏的视觉效果和玩家体验。H100 GPU 的并行处理单元可以高效处理大量图形和物理运算,减少延迟和卡顿现象。对于开发者来说,H100 GPU 的稳定性和高能效为长时间的开发和测试提供了可靠保障,助力开发者创造出更具创意和吸引力的游戏作品,是游戏开发的理想选择。其高带宽内存确保了复杂任务的顺利进行。H100 GPU 的强大图形处理能力不仅提升了游戏的视觉效果,还使得游戏运行更加流畅,玩家体验更加出色,推动了游戏开发技术的不断进步。H100 GPU 限时特惠,立刻抢购。MacowH100GPU货期

网络、存储、RAM、CPU)以及销售它的人的利润率和支持级别。该范围的**,包括支持在内的$360k-380k,是您可能期望与DGXH100相同规格的。1xHGXH100(PCIe)和8xH100GPU大约是300k美元,包括支持,具体取决于规格。PCIe卡的市场价格约为30k-32k美元。SXM卡并不是真正作为单张卡出售的,因此很难在那里给出定价。通常作为4-GPU和8-GPU服务器出售。大约70-80%的需求是SXMH100,其余的是PCIeH100。SXM部分的需求呈上升趋势,因为PCIe卡是前几个月***可用的卡。鉴于大多数公司购买8-GPUHGXH100(SXM),每360个H380的大约支出为8k-100k,包括其他服务器组件。DGXGH200(提醒一下,包含256xGH200,每个GH200包含1xH100GPU和1xGraceCPU)的成本可能在15mm-25mm之间-尽管这是一个猜测,而不是基于定价表。19需要多少个GPU?#GPT-4可能在10,000到25,000架A100之间接受过训练。20Meta拥有大约21,000架A100,特斯拉拥有约7,000架A100,稳定AI拥有约5,000架A100。21猎鹰-40B在384架A100上进行了训练。22Inflection使用3,500H100作为其。23顺便说一句,到22月,我们有3k在运行。并且***运行超过5.<>k。——穆斯塔法·苏莱曼(MustafaSuleyman)。NVLINKH100GPU促销价H100 GPU 限时降价,机会不容错过。

H100 GPU 采用了 NVIDIA 的架构技术,其架构采用 Ampere 架构,使其在性能和能效方面都达到了一个新的高度。H100 GPU 具有 8192 个 CUDA ,能够提供极高的并行处理能力,对于需要大量计算资源的任务,如深度学习训练和科学计算,H100 GPU 能够提升效率。其基础时钟频率为 1410 MHz,增强时钟频率可达 1665 MHz,确保在高负载下依然能够提供稳定的性能输出,其 Tensor Core 性能可达 312 TFLOPS,特别适合深度学习和神经网络训练等需要大量矩阵运算的任务,极大地提升了计算效率。

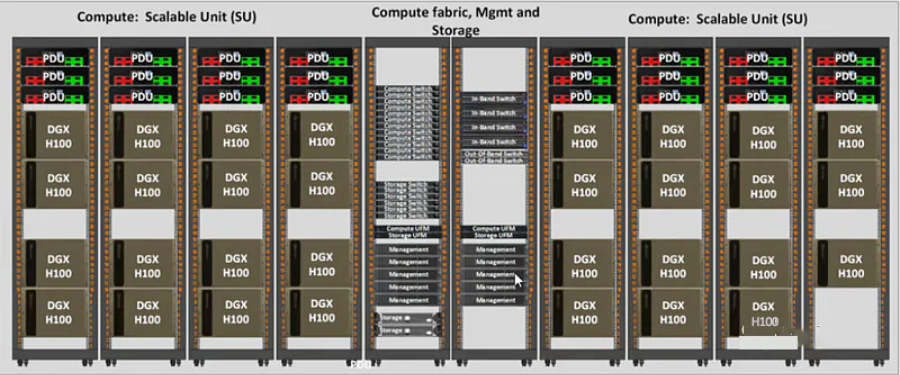

节点内部的每个NVSwitch提供64个第四代NVLink链路端口,以加速多GPU连接。交换机的总吞吐率从上一代的。新的第三代NVSwitch技术也为多播和NVIDIASHARP网络内精简的集群操作提供了硬件加速。新的NVLinkSwitch系统互连技术和新的基于第三代NVSwitch技术的第二级NVLink交换机引入地址空间隔离和保护,使得多达32个节点或256个GPU可以通过NVLink以2:1的锥形胖树拓扑连接。这些相连的节点能够提供TB/sec的全连接带宽,并且能够提供难以置信的一个exaFlop(百亿亿次浮点运算)的FP8稀疏AI计算。PCIeGen5提供了128GB/sec的总带宽(各个方向上为64GB/s),而Gen4PCIe提供了64GB/sec的总带宽(各个方向上为32GB/sec)。PCIeGen5使H100可以与性能高的x86CPU和SmartNICs/DPU(数据处理单元)接口。基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户。通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch。H100 GPU 价格直降,抢购从速。

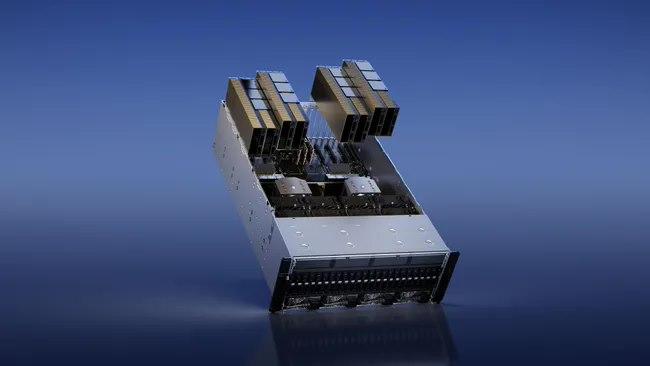

基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户,通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch,以提供SHARP在网络中的缩减和任意对GPU之间900GB/s的完整NVLink带宽。H100SXM5GPU还被用于功能强大的新型DGXH100服务器和DGXSuperPOD系统中。H100PCIeGen5GPU以有350W的热设计功耗(ThermalDesignPower,TDP),提供了H100SXM5GPU的全部能力该配置可选择性地使用NVLink桥以600GB/s的带宽连接多达两个GPU,接近PCIeGen5的5倍。H100PCIe非常适合主流加速服务器(使用标准的架构,提供更低服务器功耗),为同时扩展到1或2个GPU的应用提供了很好的性能,包括AIInference和一些HPC应用。在10个前列数据分析、AI和HPC应用程序的数据集中,单个H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,同时消耗了50%的功耗。DGXH100andDGXSuperPODNVIDIADGXH100是一个通用的高性能人工智能系统。H100 GPU 促销优惠,赶快购买。英伟达H100GPU多少钱一台

H100 GPU 提供高效的 GPU 直连技术。MacowH100GPU货期

它能够高效处候模拟、基因组学研究、天体物理学计算等复杂的科学任务。H100GPU的大规模并行处理单元和高带宽内存可以提升计算效率和精度,使科学家能够更快地获得研究成果。其稳定性和可靠性也为长时间计算任务提供了坚实保障,是科学计算领域不可或缺的工具。在大数据分析领域,H100GPU展现了其强大的数据处理能力。它能够快速处理和分析海量数据,提供实时的分析结果,帮助企业做出更快的决策。无论是在金融分析、市场预测还是用户行为分析中,H100GPU都能提升数据处理速度和分析准确性。其高能效设计不仅提升了性能,还为企业节省了大量的能源成本,成为大数据分析的硬件。H100GPU在云计算中的应用也非常。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100GPU的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,MacowH100GPU货期

- 超微H100GPU库存 2024-11-15

- DubaiH100GPU价格 2024-11-15

- QatarH100GPU库存 2024-11-15

- DubaiNVLINKH100GPU 2024-11-15

- 技嘉H100GPU促销 2024-11-15

- 重庆H100GPU总代 2024-11-15

- 香港H100GPU price 2024-11-15

- 重庆超微H100GPU 2024-11-15

- IranH100GPU促销 2024-11-15

- NVLINKH100GPU 2024-11-14

- LenovoH100GPU库存 2024-11-14

- xfusionH100GPU price 2024-11-14