- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

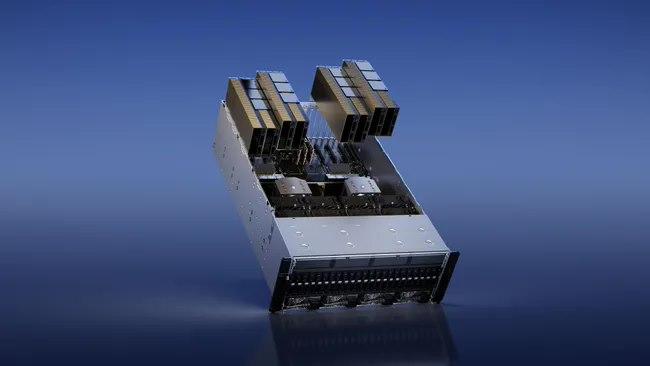

- 8 H100 80GB NVlink

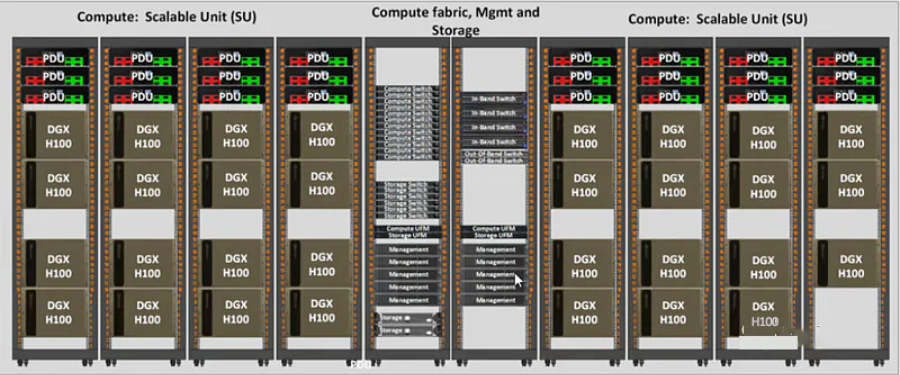

第四代NVIDIANVLink在全归约操作上提供了3倍的带宽提升,在7倍PCIeGen5带宽下,为多GPUIO提供了900GB/sec的总带宽,比上一代NVLink增加了50%的总带宽。第三代NVSwitch技术包括驻留在节点内部和外部的交换机,用于连接服务器、集群和数据中心环境中的多个GPU。节点内部的每个NVSwitch提供64个第四代NVLink链路端口,以加速多GPU连接。交换机的总吞吐率从上一代的。新的第三代NVSwitch技术也为多播和NVIDIASHARP网络内精简的集群操作提供了硬件加速。新的NVLinkSwitch系统互连技术和新的基于第三代NVSwitch技术的第二级NVLink交换机引入地址空间隔离和保护,使得多达32个节点或256个GPU可以通过NVLink以2:1的锥形胖树拓扑连接。这些相连的节点能够提供TB/sec的全连接带宽,并且能够提供难以置信的一个exaFlop(百亿亿次浮点运算)的FP8稀疏AI计算。PCIeGen5提供了128GB/sec的总带宽(各个方向上为64GB/s),而Gen4PCIe提供了64GB/sec的总带宽(各个方向上为32GB/sec)。PCIeGen5使H100可以与性能高的x86CPU和SmartNICs/DPU(数据处理单元)接口。H100 GPU 优惠直降,数量有限。北京H100GPU优惠

我们将定期举办技术交流会和培训,帮助客户更好地了解和使用 H100 GPU 产品。通过与客户的面对面交流,ITMALL.sale 不仅能够分享新的技术和产品信息,还能够深入了解客户的需求和挑战。ITMALL.sale 的技术前辈会在交流会上详细讲解 H100 GPU 的使用方法和最佳实践,解答客户的技术问题,并提供实用的建议和解决方案,帮助客户充分发挥 H100 GPU 的性能,提升业务效率。ITMALL.sale 的技术交流会不仅是客户学习和提升的机会,也是客户与行业前辈交流和合作的平台,促进技术进步和创新发展。广东H100GPU一台多少钱H100 GPU 特惠价销售,快来购买。

在未来,我们将继续加强与 NVIDIA 的合作,推出更多基于 H100 GPU 的创新解决方案。ITMALL.sale 将不断拓展产品线,满足不同领域客户的需求,并提供更多增值服务,如技术咨询、培训、定制化解决方案等。ITMALL.sale 还将继续优化物流和售后服务体系,提高客户满意度。通过不断创新和提升,ITMALL.sale 致力于成为客户优先的 H100 GPU 供应商,为客户创造更大的价值。ITMALL.sale 的目标是通过持续的技术创新和服务提升,为客户提供更好的产品和服务体验,助力客户业务的成功和发展。

每个GPU实例在整个内存系统中都有单独的和孤立的路径--片上的交叉开关端口、L2缓存库、内存控制器和DRAM地址总线都是分配给单个实例的。这保证了单个用户的工作负载可以以可预测的吞吐量和延迟运行,具有相同的L2缓存分配和DRAM带宽,即使其他任务正在冲击自己的缓存或使其DRAM接口饱和。H100MIG改进:提供完全安全的、云原生的多租户、多用户的配置。Transformer引擎Transformer模型是当今从BERT到GPT-3使用的语言模型的支柱,需要巨大的计算资源。第四代NVLink和NVLink网络PCIe以其有限的带宽形成了一个瓶颈。为了构建强大的端到端计算平台,需要更快速、更可扩展的NVLink互连。NVLink是NVIDIA公司推出的高带宽、高能效、低延迟、无损的GPU-to-GPU互连。其中包括弹性特性,如链路级错误检测和数据包重放机制,以保证数据的成功传输。新的NVLink为多GPUIO和共享内存访问提供了900GB/s的总带宽,为PCIeGen5提供了7倍的带宽。A100GPU中的第三代NVLink在每个方向上使用4个差分对(4个通道)来创建单条链路,在每个方向上提供25GB/s的有效带宽,而第四代NVLink在每个方向上使用2个高速差分对来形成单条链路,在每个方向上也提供25GB/s的有效带宽。引入了新的NVLink网络互连。H100 GPU 提供高效的数据分析能力。

网络、存储、RAM、CPU)以及销售它的人的利润率和支持级别。该范围的**,包括支持在内的$360k-380k,是您可能期望与DGXH100相同规格的。1xHGXH100(PCIe)和8xH100GPU大约是300k美元,包括支持,具体取决于规格。PCIe卡的市场价格约为30k-32k美元。SXM卡并不是真正作为单张卡出售的,因此很难在那里给出定价。通常作为4-GPU和8-GPU服务器出售。大约70-80%的需求是SXMH100,其余的是PCIeH100。SXM部分的需求呈上升趋势,因为PCIe卡是前几个月***可用的卡。鉴于大多数公司购买8-GPUHGXH100(SXM),每360个H380的大约支出为8k-100k,包括其他服务器组件。DGXGH200(提醒一下,包含256xGH200,每个GH200包含1xH100GPU和1xGraceCPU)的成本可能在15mm-25mm之间-尽管这是一个猜测,而不是基于定价表。19需要多少个GPU?#GPT-4可能在10,000到25,000架A100之间接受过训练。20Meta拥有大约21,000架A100,特斯拉拥有约7,000架A100,稳定AI拥有约5,000架A100。21猎鹰-40B在384架A100上进行了训练。22Inflection使用3,500H100作为其。23顺便说一句,到22月,我们有3k在运行。并且***运行超过5.<>k。——穆斯塔法·苏莱曼(MustafaSuleyman)。H100 GPU 适用于人工智能训练任务。SupermicroH100GPU list price

H100 GPU 的增强时钟频率可达 1665 MHz。北京H100GPU优惠

这些线程可以使用SM的共享内存与快速屏障同步并交换数据。然而,随着GPU规模超过100个SM,计算程序变得更加复杂,线程块作为编程模型中表示的局部性单元不足以大化执行效率。Cluster是一组线程块,它们被保证并发调度到一组SM上,其目标是使跨多个SM的线程能够有效地协作。GPC:GPU处理集群,是硬件层次结构中一组物理上总是紧密相连的子模块。H100中的集群中的线程在一个GPC内跨SM同时运行。集群有硬件加速障碍和新的访存协作能力,在一个GPC中SM的一个SM-to-SM网络提供集群中线程之间快速的数据共享。分布式共享内存(DSMEM)通过集群,所有线程都可以直接访问其他SM的共享内存,并进行加载(load)、存储(store)和原子(atomic)操作。SM-to-SM网络保证了对远程DSMEM的快速、低延迟访问。在CUDA层面,集群中所有线程块的所有DSMEM段被映射到每个线程的通用地址空间中。使得所有DSMEM都可以通过简单的指针直接引用。DSMEM传输也可以表示为与基于共享内存的障碍同步的异步复制操作,用于**完成。异步执行异步内存拷贝单元TMA(TensorMemoryAccelerator)TMA可以将大块数据和多维张量从全局内存传输到共享内存,反义亦然。使用一个copydescriptor。北京H100GPU优惠

- 超微H100GPU库存 2024-11-15

- DubaiH100GPU价格 2024-11-15

- QatarH100GPU库存 2024-11-15

- DubaiNVLINKH100GPU 2024-11-15

- 技嘉H100GPU促销 2024-11-15

- 重庆H100GPU总代 2024-11-15

- 香港H100GPU price 2024-11-15

- 重庆超微H100GPU 2024-11-15

- IranH100GPU促销 2024-11-15

- NVLINKH100GPU 2024-11-14

- LenovoH100GPU库存 2024-11-14

- xfusionH100GPU price 2024-11-14